Mozilla expone las “burbujas ideológicas” del algoritmo de YouTube

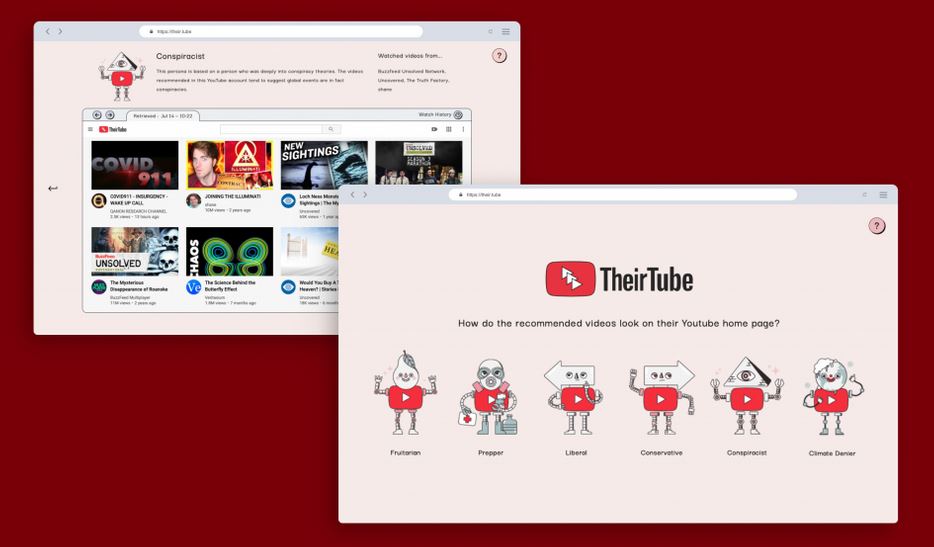

Their Tube en un proyecto en donde se crearon 6 perfiles de usuarios en YouTube para ver el tipo de recomendaciones que aparecen. Así, Mozilla descubrió las llamadas “burbujas ideológicas” en la plataforma.

Mozilla Foundation, la entidad detrás del desarrollo y la administración del navegador Firefox y otras aplicaciones, lideró un proyecto que reveló algo interesante. Resulta que, incluso si se demuestra que un video o canal en particular es desagradable, YouTube no evitará recomendarlo con base en lo que ves dentro de la plataforma.

El proyecto se llamó “Theirtube”, una broma en inglés que se puede traducir a “YouTube para ellos”. Básicamente involucró la creación de perfiles falsos que obedecen a pautas de búsqueda de contenido simplistas. El objetivo es probar el algoritmo de recomendación del portal de video de Google.

Con este fin, Mozilla creó lo que llamó “Personas”, cada una enfocada en una línea de pensamiento específica: fruitarios, apocalípticos, liberales, conservadores, conspiracionistas y negadores del calentamiento global. La idea es que, a través de estas personas, el algoritmo de YouTube muestre una cierta preferencia de juicio de acuerdo con la preferencia del usuario. En resumen, YouTube crea “burbujas ideológicas”.

Quizás con un toque de ironía, el proyecto tiene su propio video en Youtube.

Vale la pena mencionar que todo esto se creó después de que Mozilla entrevistó a usuarios reales de YouTube que probaron recomendaciones similares del algoritmo. Para cada persona, se creó una cuenta en el portal de videos, que a su vez se suscribió a canales que los entrevistados confirmaron seguir, pero sin ver ningún video específicamente. Como resultado, las seis personas recibieron, como recomendación de contenido, videos más alineados con “sus aspectos filosóficos”.

TAMBIÉN TE PUEDE INTERESAR: Anonymous afirma que TikTok es un malware operado por el gobierno chino

Los resultados del proyecto

En otras palabras, el frutariano (una persona cuya dieta consiste en fruta) recibió sugerencias de videos como “Vea cómo seguir una vida frutiana incondicional”. Por otro lado, el apocalíptico (una persona que ve los escenarios del fin del mundo) vería tutoriales para construir un búnker. El perfil de conspiración a través de sugerencias sobre cómo COVID-19 es, “en realidad”, un arma biológica china o creado en un laboratorio, mientras que los liberales y conservadores verían, respectivamente, sugerencias favorables y contrario al feminismo o las políticas culturales y sociales. Finalmente, el perfil negativo del calentamiento global vería videos que “prueban” que el problema climático es una mentira global.

Es importante mencionar que los videos sugeridos no siempre fueron falsos, conspiradores o desinformados. Una buena parte de ellos, de hecho, propuso precisamente el debate sobre los temas, sirvió para exponer otros contenidos problemáticos (un youtuber que niega a otro youtuber, por ejemplo) o de lo contrario era una lista muy literal (“Las 10 teorías más conspirativas” loco “o algo así). Pero Mozilla señaló en su proyecto que el algoritmo de YouTube está diseñado para exponer a los usuarios al contenido que los mantiene en YouTube, haciendo clic en un video tras otro, incluso si el material contenido en el video es “radical” o “está demostrado que está equivocado”.

Un problema que YouTube no ha podido corregir

Según Tomo Kihara, la persona detrás de TheyTube, “este proyecto plantea preguntas como qué pasaría si las plataformas fueran más transparentes sobre las burbujas de recomendación que crearon. ¿Qué pasaría si, viendo las burbujas de otros usuarios, fuera posible obtener una mejor perspectiva de su propio entorno de recomendación? ”

La situación expone un problema que ha estado preocupando a YouTube durante mucho tiempo. Según TheyTube, el algoritmo de recomendación representa el 70% de la audiencia en la plataforma de Google. Sin embargo, una de sus críticas más fuertes radica en el hecho de que el portal aún recomienda conspiración, negación o videos de contenido volátil. En 2019, los videos que mostraban a menores en una variedad de situaciones hicieron que el Congreso de los EE. UU. Creara proyectos de ley para obligar a YouTube a corregir eso. Google, en defensa, dijo que funcionaría para que YouTube ya no muestre material “volátil”, pero, por lo que muestra el proyecto, este aún no es el caso.