Con el arribo de la tecnología 5G se espera que entremos a una nueva era del Internet de las Cosas. Dónde gadgets integrados a Google Assistant, Siri y Alexa serían pieza vital de nuestros hogares. Pero por desgracia sería muy fácil hackearlos.

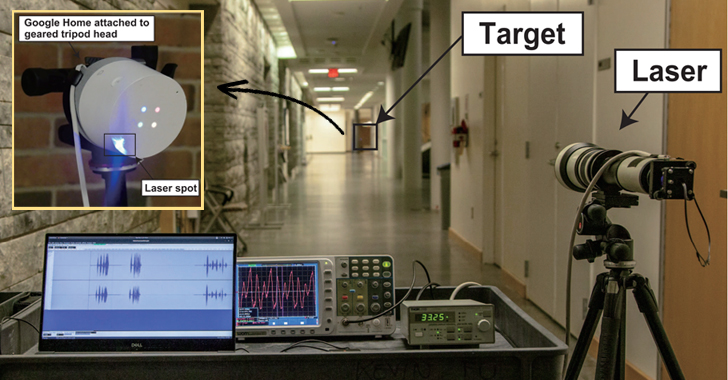

Así lo acaba de comprobar un grupo de investigadores de Tokio y la Universidad de Michigan donde usaron un apuntador láser para burlar la interfaz de comandos de voz de prácticamente cualquier dispositivo con un asistente inteligente.

Esto no es la noticia en sí, que tiene lo suyo, sino que todavía no se sabe a ciencia cierta porque estos asistentes responden a la luz como si fuera sonido.

Light Commands es una vulnerabilidad de micrófono MEMS que permite a los atacantes inyectar de manera remota comandos inaudibles e invisibles en asistentes de voz, como Google Assistant, Alexa, y Siri.

Y es a una distancia de 110 metros desde la que se puede proyectar luz láser de baja frecuencia para activar esos sistemas de voz en los que se “inyecta” comandos que luego ejecutan acciones muy variadas. Estos investigadores incluso han sido capaces de enviar este tipo de comandos de luz desde un edificio a otro y atravesar el cristal para llegar al dispositivo con Google Assistant o Siri.

Por lo que podemos saber, el ataque se aprovecha de una vulnerabilidad existente en los micrófonos y que usa lo llamado como MEMS (micro-electro-mecánicos sistemas). Los componentes microscópicos MEMS involuntariamente responden a la luz como si fuera sonido.

¿Cómo funcionan los comandos de luz?

Al dirigir el láser a través de la distancia a los micrófonos que se encuentran dentro de los parlantes inteligentes, tabletas o teléfonos, un atacante lejano puede enviar comandos inaudibles sobre los que Alexa, Assistant o Siri.

Para empeorar las cosas, una vez que un atacante ha obtenido el control sobre un asistente de voz, el atacante puede usarlo para romper otros sistemas. Por ejemplo, el atacante puede:

- Controla los interruptores inteligentes del hogar

- Abrir puertas de garaje inteligentes

- Hacer compras en línea

- Desbloquee y arranque ciertos vehículos de forma remota

- Abrir las cerraduras inteligentes al forzar sigilosamente el número PIN del usuario.

¿Pero por qué sucede esto?

Los micrófonos convierten el sonido en señales eléctricas. El principal descubrimiento detrás de los comandos de luz es que, además del sonido, los micrófonos también reaccionan a la luz dirigida directamente a ellos. Por lo tanto, al modular una señal eléctrica en la intensidad de un haz de luz, los atacantes pueden engañar a los micrófonos para que produzcan señales eléctricas como si estuvieran recibiendo audio genuino.

Una nueva forma de ataque

Este tipo de ataques tienen una serie de limitaciones. El primero es que el atacante ha de tener línea directa de visión con el dispositivo al que quiere atacar. El segundo, y es que la luz ha de ser enfocada de forma muy precisa en una parte muy específica del micrófono. También hay que tener en cuenta que a no ser que el atacante use un láser infrarrojo, la luz se vería de forma fácil por cualquiera que esté cerca del dispositivo.

También llama la atención que esta serie de dispositivos controlados por voz no llevan consigo algún tipo de requerimiento de contraseña o PIN. Es decir, que, si eres capaz de “hackearlos” con este tipo de emisión por luz, puedes controlar todo un hogar en el que un Google Assistant o Siri controle las luces, el termostato, cierre de puertas y más. Casi de película.

¿Qué dispositivos son susceptibles a los comandos de luz?

En este experimento, se probaron ataque a los sistemas de reconocimiento de voz más populares, a saber, Alexa, Siri, y Assistant. Se compararon múltiples dispositivos, como altavoces inteligentes, teléfonos y tabletas, así como dispositivos de terceros con reconocimiento de voz incorporado.

El IoT traerá consigo nuevas implicaciones y será momento de empezar a tomar nuestras propias precauciones.